1.はじめに

2023.11.21に Stability AIは、静止画から動画を生成するImage2Videoモデルとして、SVD(Stable Video Diffusion)を公開しました。早速試してみたいと思います。

2.SVDとは?

今まで静止画から動画を生成する技術としては、Pikaやgen2などがありました。今回、Stability AIが、同種の技術として投入したのが、SVDです。

今回提供されたモデルには、2つのタイプがあります。1つは、解像度576×1024で毎秒14フレームのSVD。もう1つは、解像度576×1024で毎秒25フレームのSVD-XTです。

それでは、早速試してみましょう。

3.使い方

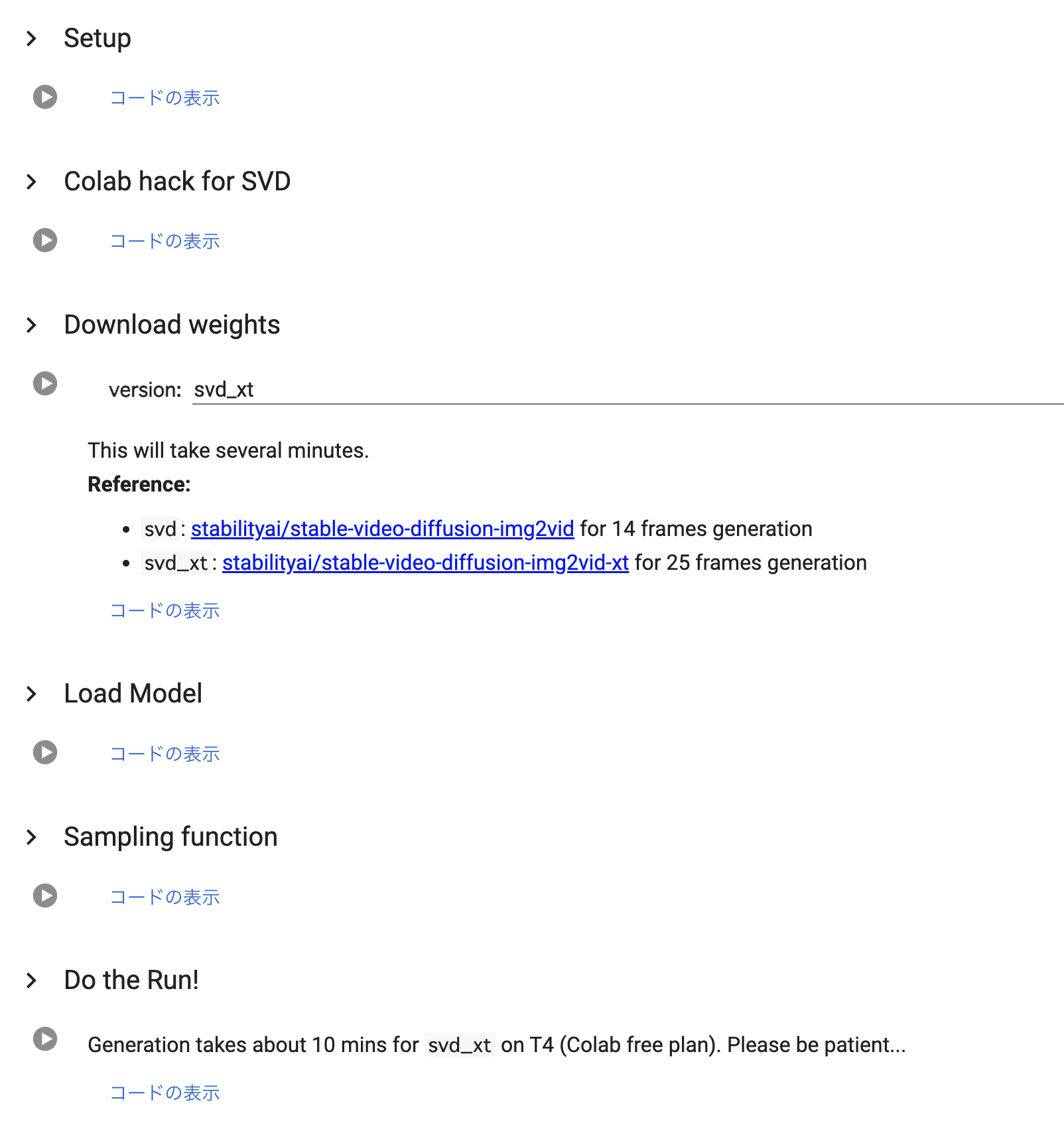

この[リンク]をクリックするとcolabが動かせます。なお、このコードは@mkshing氏によって作成されたものです。

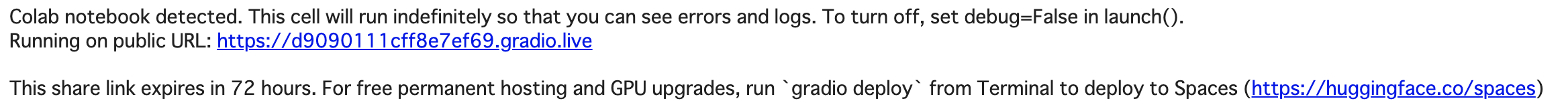

使い方は、上から順番に実行して行くだけです。ログの最後に、Running on public URL : が表示されたらクリックすると、別タブにWebGUIが表示されます。

これが、WebGUIです。input imageに画像をアップロードし、Runボタンを押すと、10分程度でgenerated video に動画が生成されます。

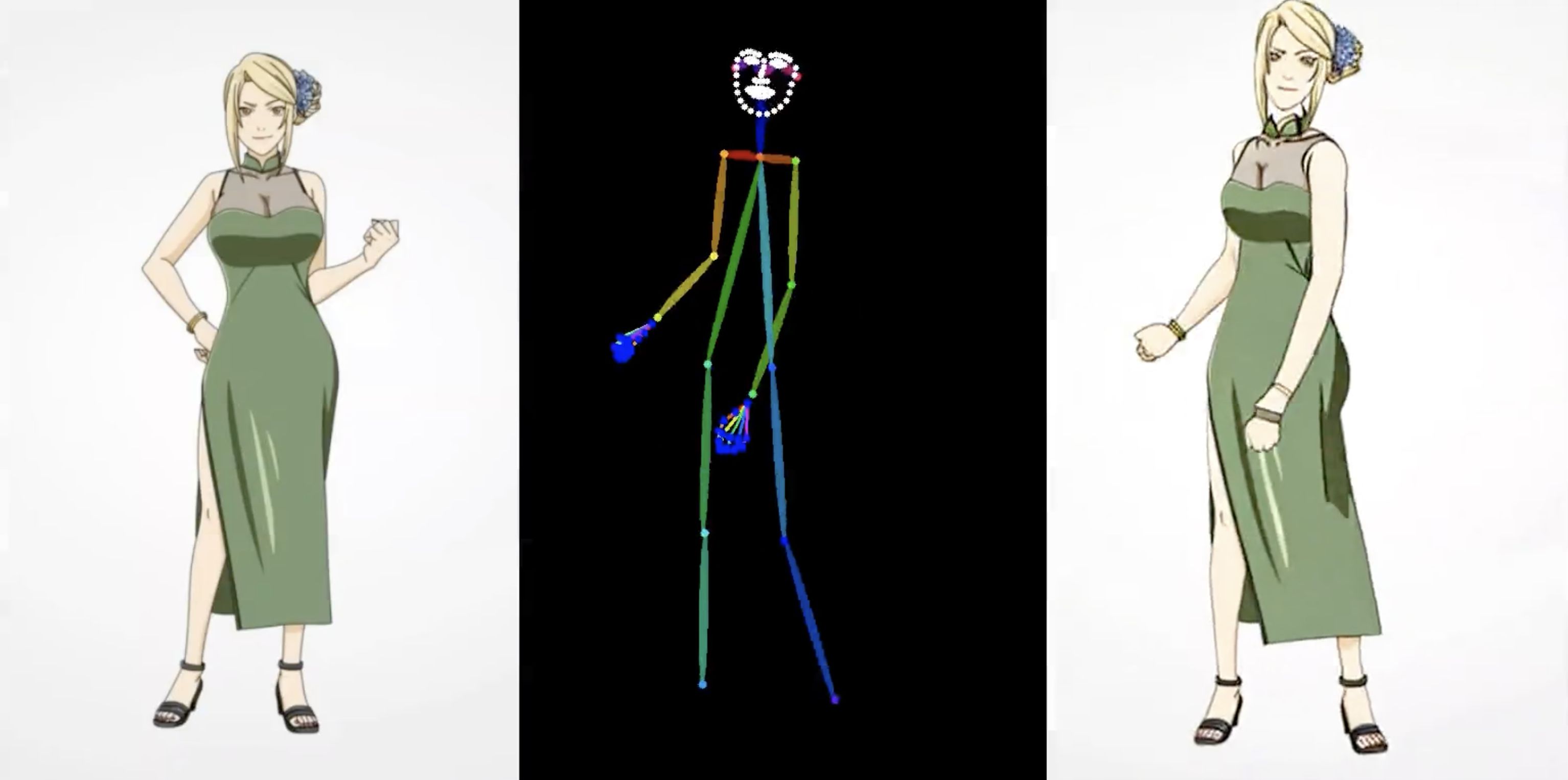

実際に生成した動画の例を2つを見てみましょう。どちらも静止画は、Midjourney v6.0で生成したものを使っています。

Pikaやgen2と比べると、顔の表情変化に乏しいところはありますが、全体的な動きについては、むしろいい感じに仕上がっているような気がします。

このImage2Videoモデルに関しても、今後大きな技術的なブレイクスルーが楽しみですね。では、また。

(オリジナルgithub)https://github.com/Stability-AI/generative-models

コメントを残す